Det koster selvfølgelig penge at drive sine softwareløsninger.

Hvis man driver dem on-premise risikerer man at have indkøbt for meget hardware for at kunne følge med et muligt forretnings- og udviklingsbehov eller for at klare spidsbelastninger - men i cloud behøver man ikke at provisionere for mange ressourcer, så projekter og organisationer kan jo helt undgå dén situation. Derved kan IT-chefen læne sig tilbage og stole på få optimal værdi for sit budget? Eller hvad?

Der er to klassiske situationer hvor man provisionerer for mange eller for store ressourcer i skyen. Det positive scenarie: Organisationen starter mange nye projekter og er meget innovativ. Det negative scenarie: Der er ikke opbygget tilstrækkelig viden om IT-driften i skyen. Provisioneringen sker på andre præmisser end ved traditionel on-premise drift, hvor man kun får nye eller større ressourcer, når driftsafdelingen installerer dem.

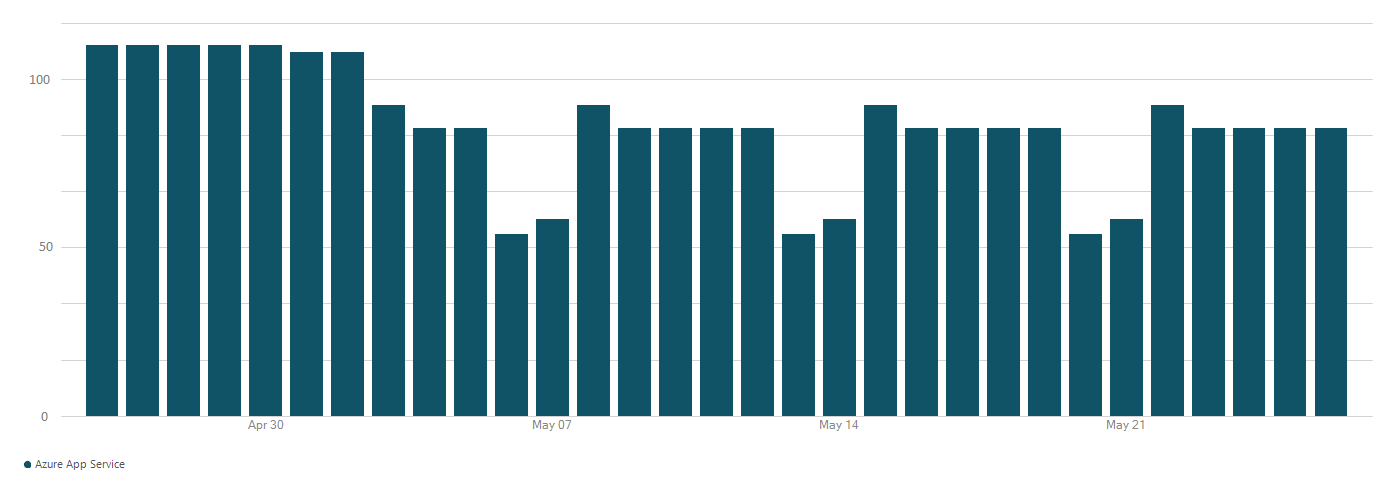

Uanset hvad er det muligt at styre de omkostninger, man har i skyen. Der kan opsættes overvågning, stilles krav om at driftsafdelingen er inde over provisionering af nye ressourcer og man kan jævnligt rydde op. Det kræver nye kompetencer i driftsafdelingen at tage dét ansvar på sig, på en ny måde.

Man kan derudover stille fokus på omkostninger som et krav til DevOps-projekter i organisationen. Denne blog er funderet i et DevOps-mindset, men principperne kan også bruges i en organisation, hvor udvikling og drift er opdelt.

I det følgende nævnes ind-/ud-/op-/ned skalering. Det kan sammenlignes med spande – hvis man skalerer op og ned, så skifter man størrelsen på spandene. Hvis man skalerer ud og ind, så tilføjer eller fjerner man spande.